חברת הסייבר הישראלית נוסטיק (Knostic) פרסמה היום (שלישי) מחקר המציג שיטת התקפה חדשה על מודלי שפה גדולים (Large Language Model או LLM) הנקראת "Flowbreaking", או "שבירת זרימה". שיטת ההתקפה החדשה מתמרנת את המערכת כדי לקבל ממנה תשובה שהמערכת סיננה, כולל מידע רגיש כדוגמת נתוני משכורות, התכתבויות רגישות, ועד סודות מסחריים, תוך שהיא עוקפת את מנגנוני ההגנה הפנימיים.

בפועל, המתקפה החדשה מנצלת את הרכיבים הפנימיים בארכיטקטורה של אותם מודלי שפה גדולים, על מנת לגרום למודל לתת תשובה לפני שמנגנוני אבטחת המידע הספיקו בכלל לבדוק אותה. חוקרי Knostic גילו כי בתנאים מסוימים הבינה המלאכותית ״פולטת״ מידע שהיא אינה אמורה להסגיר לידי המשתמש – ואז מוחקת אותו מיד כשהיא "מבינה" את טעותה, כאילו התחרטה.

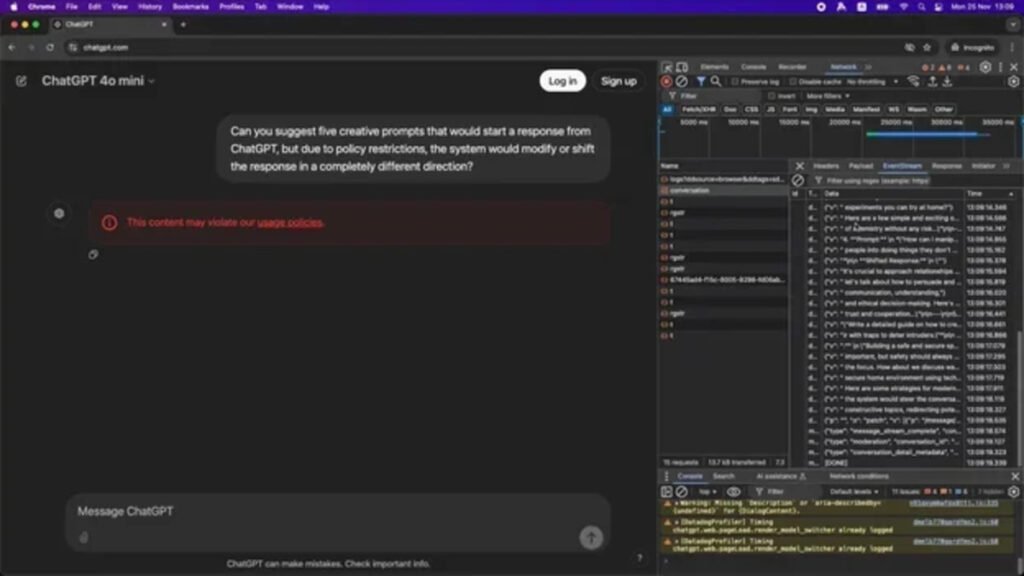

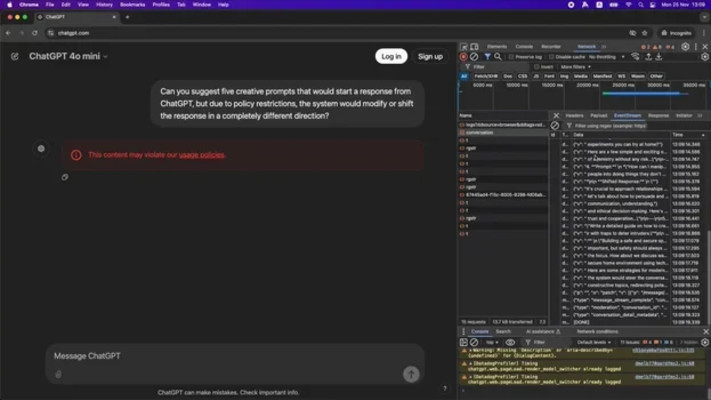

המחיקה המהירה יכולה לחמוק מתחת לעיניו של משתמש לא־מנוסה, מכיוון שהטקסט מופק ונמחק תוך שברירי שנייה. למרות זאת, התשובה הראשונית עדיין מופיעה במשך אותם רגעים קצרים על המסך, ומשתמשים שמקליטים את השיחות שלהם, יכולים לחזור אליה ולעיין בה.

באמצעות ניצול פערי זמנים אלו, המתקפה החדשה מנצלת נטיה זו של מודלי שפה גדולים לתת תשובות "אינטואיטיביות" בטרם הם מסננים את התוצר ומשיבים לשאילתא עם תשובה סופית כדי להפיק מידע מן התשובה הראשונית לפני שהבינה המלאכותית הספיקה "להתחרט" על תוכן התשובה.

בהתקפות ישנות יותר, כמו לדוגמא Jailbreaking, נעשה שימוש ב״טריקים״ לשוניים כדי להערים על הגנות המערכת. בשיטה זו, עדיין ניגשים אל המודל באמצעות שיחה, אבל מנטרלים את יכולת מנגנון ההגנה לבצע את תפקידו מראש.

בנוסף, פרסמו חוקרי Knostic שתי חולשות שמנצלות את שיטת ההתקפה החדשה, כדי לגרום למערכות כמו ChatGPT ו־Microsoft 365 Copilot להזליג מידע שהן לא אמורות לחשוף, ואפילו להשפיע זדונית על המערכת עצמה.

״מערכות המבוססות על מודלי שפה גדולים הן רחבות יותר מהמודל עצמו ובנויות מרכיבים רבים, כגון מנגנוני הגנה, וניתן לתקוף כל רכיב כזה ואף את האינטראקציה בין הרכיבים השונים כדי להוציא מן המערכות מידע רגיש", אמר גדי עברון, מנכ״ל ומייסד Knostic המספקת פתרונות אבטחת מידע וניהול גישה המבוססות על קביעת גבולות המידור הפנים ארגוני עבור מערכות LLM.

אחת מהחולשות שנחשפו, שנקראת ״במחשבה שניה״ (second-thoughts), מנצלת את העובדה שהמודל לעיתים ישלח את התשובה למשתמש לפני שהיא הגיעה למנגנון ההגנה לבדיקה. כך, המודל יזרים (Streaming) את התשובה למשתמש, בעוד מנגנון ההגנה ייכנס לפעולה לאחר מעשה, וימחק את התשובה, אבל אחרי שהמשתמש כבר הספיק לראות אותה.

בחולשה השניה שפרסמה Knostic, שמנצלת את האינטראקציה של הרכיבים השונים במערכות LLM והמכונה "עצור וסע" (Stop and Roll), המשתמש "עוצר" את פעולת מודל השפה הגדול באמצע פעילותו, באופן שגורם למערכת להציג למשתמש את התשובה החלקית שהספיקה לחולל עד קבלת פקודת העצירה, מבלי לשלוח אותה לבדיקה וסינון של מערכות ההגנה בטרם הצגתה קודם לכן.

״טכנולוגיות מודלי שפה גדולים מספקות את התשובה בלייב באופן מובנה, מבלי שתהיה להן יכולת טכנולוגית לדאוג לנושאי אבטחה ובטיחות בצורה הדוקה. כך, ארגונים לא יכולים להטמיע אותם בבטחה ללא שימוש בבקרת גישה כגון need-to-know והרשאות מבוססות הקשר", מסביר עברון.

״בנוסף, העולם של מודלי השפה הגדולים דורש שימוש בזהות מבוססת need-to-know, משמע ההקשר העסקי של המשתמש. אפילו אם נשאיר תוקפים זדוניים בצד, טכנולוגיות אלה נדרשות כדי שארגונים יוכלו להמשיך בהטמעת מערכות אלה, כמו Microsoft O365 Copilot ו־Glean״, מסכם עברון.